Teknik Terbaru MIT Membentengi Gambar Anda Dari Manipulasi AI

Apa ceritanya

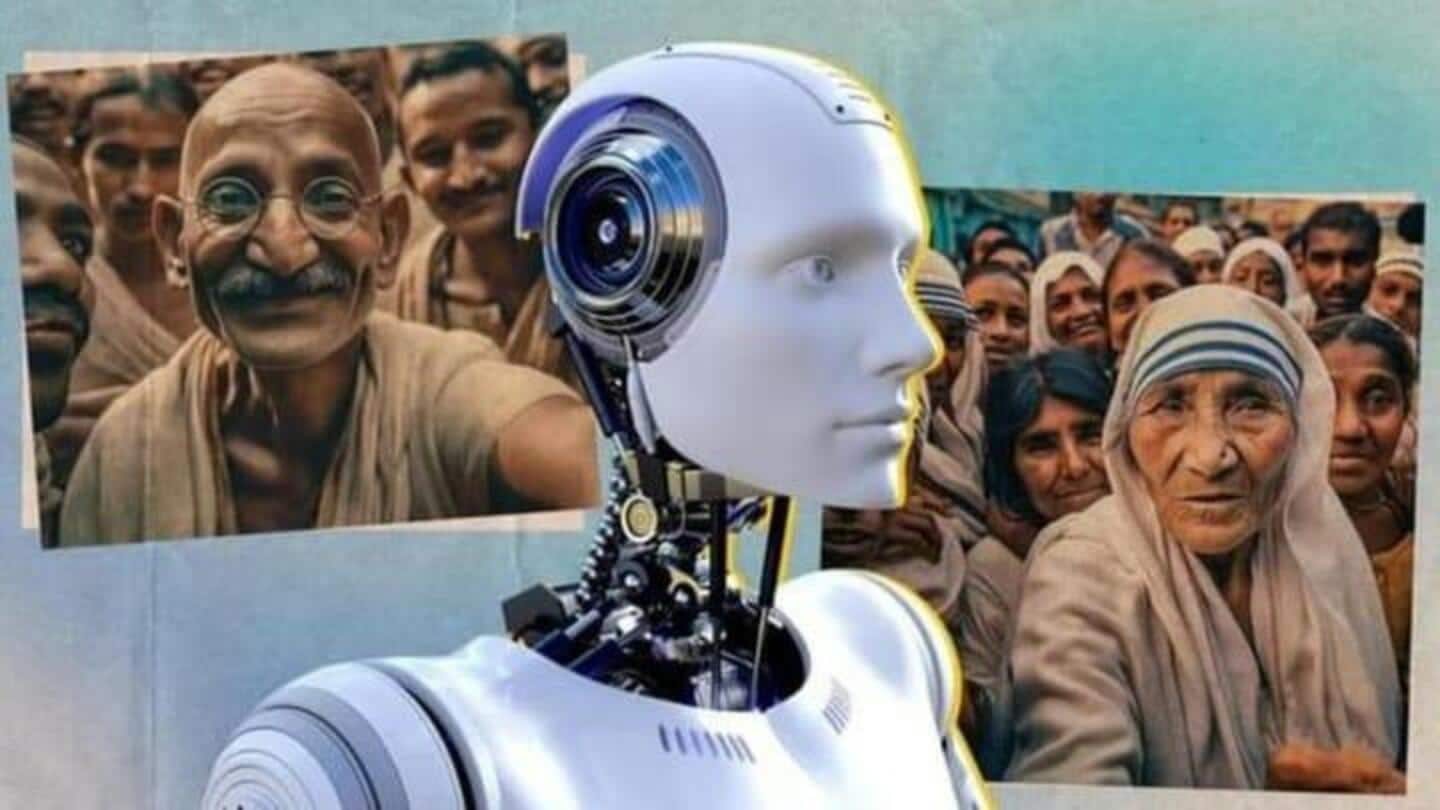

Peneliti MIT telah menciptakan "PhotoGuard," sebuah teknik yang melindungi gambar dari manipulasi kecerdasan buatan (AI) dengan menggunakan perubahan piksel kecil yang disebut perturbasi. Perubahan ini tidak terlihat oleh kita tetapi dapat dideteksi oleh model komputer. Alat tersebut akan sangat membantu dalam memerangi peningkatan risiko penyalahgunaan AI di era model canggih seperti DALL-E dan Midjourney.

1

Serangan Encoder Membuat Penyesuaian Kecil Pada Representasi Laten Gambar

PhotoGuard menggunakan dua metode "serangan": serangan "encoder", yang membuat model AI melihat gambar secara acak, dan serangan "difusi" yang lebih canggih, yang menentukan "gambar target dan mengoptimalkan gangguan untuk membuat gambar akhir menyerupai gambar target semirip mungkin." Serangan "encoder" bekerja dengan menambahkan penyesuaian kecil pada representasi laten gambar. Hal ini membuat manipulasi gambar hampir tidak mungkin dilakukan.

2

Serangan Difusi Bekerja Dengan Mengambil Model Dari Gambar Itu Sendiri

Serangan difusi, di sisi lain, menargetkan seluruh model difusi. Serangan difusi membuat perubahan "kecil, tidak terlihat" pada gambar asli yang membuatnya tampak seperti gambar target pada model AI. Hal ini akan membuat model secara tidak sengaja membuat perubahan pada gambar asli seolah-olah berhadapan dengan gambar target.

3

Konsekuensi Yang Mengkhawatirkan Dari Manipulasi AI

Model gambar AI dapat digunakan untuk mengubah gambar yang tidak berbahaya menjadi perubahan yang berbahaya. Laboratorium Ilmu Komputer dan Kecerdasan Buatan (CSAIL) MIT mengembangkan PhotoGuard untuk mengatasi ancaman ini. Manipulasi gambar AI dapat memengaruhi tren pasar, opini publik, dan citra pribadi, yang menyebabkan konsekuensi di sektor keuangan yang signifikan. Dalam kasus ekstrim, model ini bahkan dapat digunakan untuk melakukan kejahatan palsu menggunakan simulasi suara dan gambar.

4

Mengatasi Tantangan Untuk Visual Yang Aman

PhotoGuard membantu pertahanan dambar dari manipulasi AI yang tidak sah sambil menjaga integritas visual gambar. Serangan difusi akan lebih intensif terhadap sumber gambarnya dan membutuhkan memori GPU yang besar. Peneliti menyarankan untuk menggunakan lebih sedikit langkah dalam proses difusi agar teknik ini dapat berjalan lebih praktis. Menambahkan perturbasi sebelum mengunggah gambar dapat melindunginya dari modifikasi, tetapi hasil akhirnya mungkin kurang realistis dibandingkan dengan gambar asli yang tidak dibentengi PhotoGuard.